Создайте надежную непрерывную интеграцию с Docker и друзьями

Оглавление

- Получите общее представление об архитектуре проекта

- Настройте Docker на своем компьютере

- Разработать систему отслеживания просмотров страниц в Flask

- Протестируйте и обезопасьте свое веб-приложение

- Настройте настройки вашего веб-приложения Flask

- Понимать терминологию Docker

- Изучите анатомию файла Dockerfile

- Выберите базовое изображение Docker

- Изолируйте свой образ Docker

- Кэшируйте зависимости вашего проекта

- Запускайте тесты как часть процесса сборки

- Укажите команду для запуска в контейнерах Docker

- Реорганизуйте свой файл Dockerfile для многоступенчатых сборок

- Создайте и обновите свой образ Docker

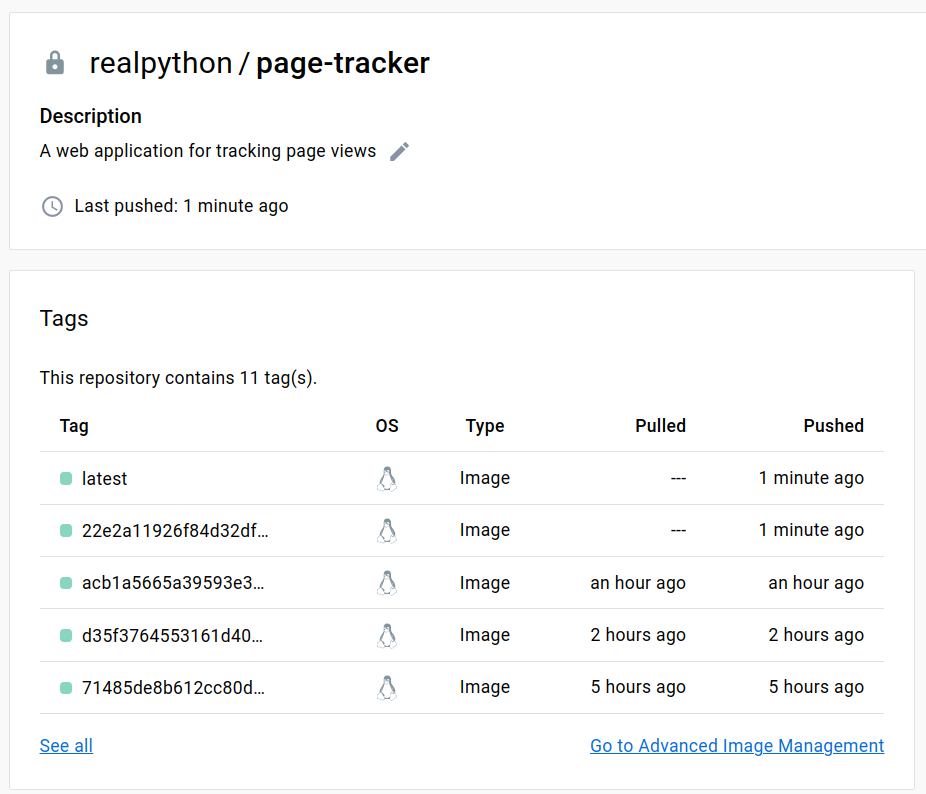

- Переместите изображение в реестр Docker

- Запустите контейнер Docker

- Организуйте контейнеры с помощью Docker Compose

- Определите конвейер непрерывной интеграции на основе Docker

- Следующие шаги

- Заключение

Непрерывная интеграция (CI) стала неотъемлемой частью разработки программного обеспечения, позволяя командам часто объединять изменения в коде и выявлять ошибки на ранней стадии. Контейнеры Docker помогают упростить процесс непрерывной интеграции, предоставляя согласованную среду, в которой вы можете тестировать и отправлять код при каждой фиксации.

В этом руководстве вы узнаете, как использовать Docker для создания надежного конвейера непрерывной интеграции для веб-приложения Flask. Вы пройдете этапы разработки и тестирования приложения локально, его контейнеризации, организации контейнеров с помощью Docker Compose и определения конвейера CI с помощью GitHub Actions. К концу этого руководства вы сможете создавать полностью автоматизированный конвейер CI для своих веб-приложений.

В этом руководстве вы узнаете:

- Запустите сервер Redis локально в контейнере Docker

- Доработать веб-приложение на Python , написанное на Flask

- Создайте образов Docker и отправьте их в Docker Hub реестр

- Управление многоконтейнерными приложениями с помощью Docker Compose

- Реплицировать производственную инфраструктуру в любом месте

- Определите рабочий процесс непрерывной интеграции с помощью Действий на GitHub

В идеале у вас должен быть некоторый опыт работы с веб-разработкой на Python, автоматизацией тестирования, использованием Redis с помощью Python и управление версиями исходного кода с помощью Git и GitHub. Предыдущее знакомство с Docker было бы плюсом, но не обязательно. У вас также должен быть клиент Git и учетная запись на GitHub, чтобы следовать инструкциям этого руководства и повторять их.

Примечание: Это руководство в общих чертах основано на более старом руководстве под названием Docker в действии - лучше, счастливее, продуктивнее, которое было автор: Майкл Герман, который представил свой CI workflow на PyTennessee 8 февраля 2015 года. Если вам интересно, вы можете просмотреть соответствующие слайдов, представленные на конференции.

К сожалению, многие инструменты, описанные в оригинальном руководстве, больше не поддерживаются или не доступны бесплатно. В этом обновленном руководстве вы будете использовать новейшие инструменты и технологии, такие как GitHub Actions.

Если вы хотите пропустить начальные шаги по настройке Docker на вашем компьютере и созданию примера веб-приложения, перейдите сразу к определению конвейера непрерывной интеграции. В любом случае, вы захотите загрузить вспомогательные материалы, которые прилагаются к готовому веб-приложению Flask, и связанные с ним ресурсы, которые помогут вам следовать этому руководству:

Ознакомьтесь с архитектурой проекта

К концу этого руководства у вас будет веб-приложение Flask для отслеживания просмотров страниц, постоянно хранящееся в хранилище данных Redis. Это будет многоконтейнерное приложение, созданное с помощью Docker Compose, которое вы сможете создавать и тестировать как локально, так и в облаке, прокладывая путь к непрерывной интеграции:

Приложение состоит из двух контейнеров Docker. В первом контейнере будет запущено приложение Flask поверх Gunicorn, отвечающее на HTTP-запросы и обновляющее количество просмотров страниц. Во втором контейнере будет запущен экземпляр Redis для постоянного хранения данных о просмотре страниц в локальном томе на главном компьютере.

Для запуска этого приложения требуется только Docker, и сейчас вы его настроите.

Настройка Docker на Вашем компьютере

Docker - это обобщающий термин, который может иметь несколько разных значений для разных людей в зависимости от контекста. Например, когда кто-то ссылается на docker, это может означать одно из следующих значений:

- Docker, Inc.: Компания, стоящая за платформой и связанными с ней инструментами

- Docker: Контейнерная платформа с открытым исходным кодом

- Docker CLI: Клиентская программа командной строки

docker dockerd: Демон Docker , который управляет контейнерами

Существует также несколько инструментов и проектов, связанных с платформой Docker, таких как:

- Docker Compose

- Рабочий стол Docker

- Движок Docker

- Концентратор докеров

- Режим Docker Swarm

В этом руководстве вы будете использовать все, кроме последнего, из приведенного выше списка. Кстати, не путайте устаревший Docker Classic Swarm, который был внешним инструментом, с Режимом Docker Swarm, встроенным в движок Docker начиная с версии 1.12.

Примечание: Возможно, вы слышали о Docker Machine и Docker Toolbox. Это старые инструменты, которые больше не обслуживаются.

Основная проблема, которую решает Docker, - это возможность запускать приложения в любом месте в согласованных и воспроизводимых средах практически без настройки. Он может упаковывать код вашего приложения, двоичные файлы и зависимости, такие как языковые среды выполнения и библиотеки, в единый артефакт. Вы будете использовать Docker для моделирования гипотетической производственной среды на вашем локальном компьютере во время разработки и на сервере непрерывной интеграции.

У вас есть два варианта установки Docker:

Если вы чувствуете себя комфортно в терминале и цените дополнительный уровень контроля, то вам стоит обратить внимание на движок Docker с открытым исходным кодом , который предоставляет основную среду выполнения и интерфейс командной строки для управление вашими контейнерами. С другой стороны, если вы предпочитаете универсальное решение с интуитивно понятным графическим интерфейсом пользователя, то вам следует рассмотреть Рабочий стол Docker.

Примечание: В комплекте с настольным приложением поставляется Docker Compose, который понадобится вам позже, когда вы будете управление контейнерами для непрерывной интеграции.

Когда вы просматриваете официальную документацию по Docker, у вас может сложиться впечатление, что в центре внимания находится Docker Desktop. Это действительно фантастический инструмент, но вы должны помнить, что Docker Desktop остается бесплатным только для личного использования.

Хотя технически возможно установить оба инструмента параллельно, вам, как правило, следует избегать их одновременного использования, чтобы свести к минимуму риск любых потенциальных помех между их виртуальными сетями или привязками портов. Вы можете сделать это, остановив один из них и переключив контекст между Docker Engine и Docker Desktop.

Примечание: Раньше Docker Desktop был доступен только в Windows и macOS, но теперь это изменилось, и вы можете установить его и в некоторые дистрибутивы Linux, включая Ubuntu, Debian и Fedora. Однако Linux-версия Docker Desktop работает поверх виртуальной машины , чтобы имитировать работу пользователя с ней в других операционных системах.

Чтобы убедиться, что вы успешно установили Docker в свою систему либо как движок Docker Engine, либо как приложение-оболочку Docker Desktop, откройте терминал и введите следующую команду:

$ docker --version

Docker version 23.0.4, build f480fb1

Вы должны увидеть свою версию Docker вместе с номером сборки. Если вы используете Linux, то, возможно, захотите выполнить шаги после установки, чтобы использовать команду docker, не предваряя ее символом sudo для получения административных привилегий.

Прежде чем вы сможете начать использовать Docker для обеспечения непрерывной интеграции, вам необходимо создать элементарное веб-приложение.

Разработать систему отслеживания просмотров страниц в Flask

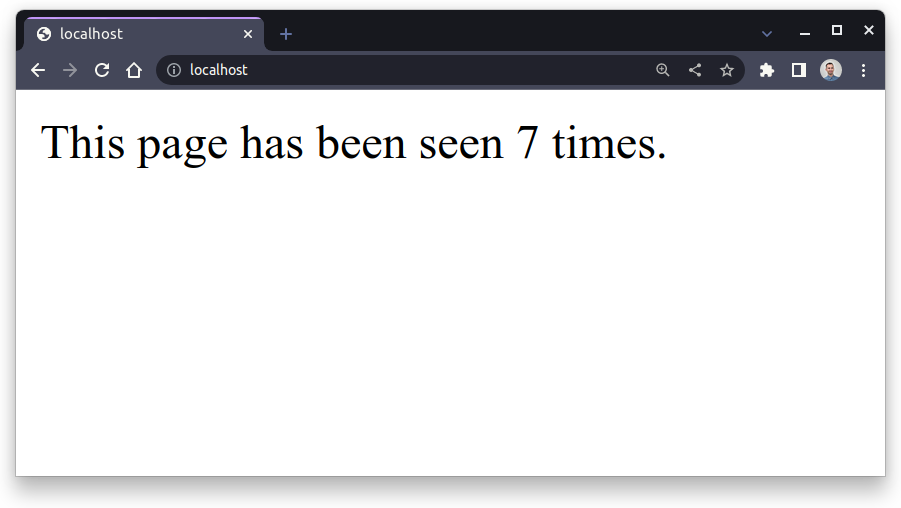

В следующих нескольких разделах вы будете реализовывать простое веб-приложение, используя фреймворк Flask. Ваше приложение будет отслеживать общее количество просмотров страниц и отображать это число пользователю при каждом запросе:

Веб-Приложение Для Отслеживания Просмотров Страниц

Веб-Приложение Для Отслеживания Просмотров Страниц

Текущее состояние приложения будет сохранено в хранилище данных Redis, которое обычно используется для кэширования и других типов сохранения данных. Таким образом, остановка вашего веб-сервера не приведет к сбросу количества просмотров. Вы можете рассматривать Redis как своего рода базу данных.

Если вы не заинтересованы в создании этого приложения с нуля, то можете скачать его полный исходный код, перейдя по ссылке ниже, и перейти к настройке вашего веб-приложения Flask:

Скачать бесплатно: Нажмите здесь, чтобы загрузить ваше приложение Flask и связанные с ним ресурсы , чтобы вы могли определить конвейер непрерывной интеграции с Docker.

Даже если вы собираетесь написать код самостоятельно, все равно неплохо загрузить готовый проект и использовать его в качестве ссылки для сравнения с вашей реализацией на случай, если вы застрянете.

Прежде чем приступить к разработке приложения, вам необходимо настроить рабочую среду.

Подготовьте окружающую среду

Как и в случае с любым проектом на Python, при запуске вы должны выполнить примерно те же шаги, которые включают создание нового каталога, а затем создание и активацию изолированной виртуальной среды для вашего проекта. Вы можете сделать это непосредственно из вашего любимого редактора кода, такого как Visual Studio Code или полноценной среды IDE, такой как PyCharm, или вы можете ввести несколько команд в терминале :

S> mkdir page-tracker

PS> cd page-tracker

PS> python -m venv venv --prompt page-tracker

PS> venv\Scripts\activate

(page-tracker) PS> python -m pip install --upgrade pip

$ mkdir page-tracker/

$ cd page-tracker/

$ python3 -m venv venv/ --prompt page-tracker

$ source venv/bin/activate

(page-tracker) $ python -m pip install --upgrade pip

Сначала создайте новый каталог с именем page-tracker/, а затем создайте виртуальную среду Python с именем venv/ прямо внутри него. Предоставьте виртуальной среде приглашение с описанием, чтобы ее было легко распознать. Наконец, после активации вновь созданной виртуальной среды обновите pip до последней версии, чтобы избежать возможных проблем при установке пакетов Python в будущем.

Примечание: В Windows вам может потребоваться сначала запустить Windows Terminal от имени администратора и ослабить политика выполнения скрипта перед созданием виртуальной среды.

В этом руководстве вы будете использовать современный способ определения зависимостей и метаданных вашего проекта с помощью pyproject.toml файла конфигурации и инструментов настройки в качестве серверной части сборки. Кроме того, вы будете следовать инструкции src layout, поместив исходный код вашего приложения в отдельный подкаталог src/, чтобы лучше упорядочить файлы в вашем проекте. Это упростит упаковку вашего кода без автоматических тестов, которые вы добавите позже.

Продолжайте и создайте заполнитель вашего проекта Python, используя следующие команды:

page-tracker) PS> mkdir src\page_tracker

(page-tracker) PS> ni src\page_tracker\__init__.py

(page-tracker) PS> ni src\page_tracker\app.py

(page-tracker) PS> ni constraints.txt

(page-tracker) PS> ni pyproject.toml

(page-tracker) $ mkdir -p src/page_tracker

(page-tracker) $ touch src/page_tracker/__init__.py

(page-tracker) $ touch src/page_tracker/app.py

(page-tracker) $ touch constraints.txt

(page-tracker) $ touch pyproject.toml

Когда вы закончите, у вас должна быть следующая структура каталогов:

page-tracker/

│

├── src/

│ └── page_tracker/

│ ├── __init__.py

│ └── app.py

│

├── venv/

│

├── constraints.txt

└── pyproject.toml

Как вы можете видеть, у вас будет только один модуль Python, app, определенный в пакете с именем page_tracker, который находится внутри каталога src/. В файле constraints.txt будут указаны закрепленные версии зависимостей вашего проекта, чтобы обеспечить повторяемых установок.

Этот проект будет зависеть от двух внешних библиотек, Flask и Redis, которые вы можете объявить в своем pyproject.toml файл:

# pyproject.toml

[build-system]

requires = ["setuptools>=67.0.0", "wheel"]

build-backend = "setuptools.build_meta"

[project]

name = "page-tracker"

version = "1.0.0"

dependencies = [

"Flask",

"redis",

]

Обратите внимание, что здесь обычно не указываются версии зависимостей. Вместо этого вы можете заморозить их вместе с любыми переходными зависимостями в требованиях или файл ограничений. Первый указывает pip, какие пакеты следует установить, а второй применяет определенные версии переходных зависимостей пакетов, напоминающие Pipenv или Poetry заблокировать файл.

Чтобы сгенерировать файл ограничений, вы должны сначала установить свой проект page-tracker в активную виртуальную среду, которая предоставит необходимые внешние библиотеки из Индекса пакетов Python (PyPI). Убедитесь, что вы создали нужную структуру папок, а затем выполните следующие команды:

(page-tracker) $ python -m pip install --editable .

(page-tracker) $ python -m pip freeze --exclude-editable > constraints.txt

Даже если вы еще не ввели ни строчки кода, Python распознает и установит заполнитель вашего пакета. Поскольку ваш пакет соответствует макету src, его удобно устанавливать в редактируемом режиме во время разработки. Это позволит вам вносить изменения в исходный код и немедленно отражать их в виртуальной среде без повторной установки. Однако вы хотите исключить редактируемый пакет из файла ограничений.

Примечание: Созданный файл ограничений очень полезен, если вы планируете поделиться своим проектом. Это означает, что кто-то другой может запустить следующую команду в своем терминале, чтобы воспроизвести ту же среду, что и у вас:

(page-tracker) $ python -m pip install -c constraints.txt .

Поскольку вы указали файл ограничений с помощью опции -c, pip установили закрепленные зависимости вместо последних доступных. Это означает, что у вас есть возможность повторной установки. Позже вы будете использовать аналогичную команду для создания образа Docker.

Хорошо. Вы почти готовы приступить к написанию кода для вашего веб-приложения Flask. Перед этим вы на мгновение переключитесь и подготовите локальный сервер Redis для подключения по сети.

Запустите сервер Redis через Docker

Название Redis представляет собой комбинацию слов удаленный сервер словарей, который довольно точно передает свое назначение как удаленного хранилища структуры данных в памяти. Являясь хранилищем ключей и значений, Redis подобен удаленному словарю Python, к которому вы можете подключиться из любого места. Она также считается одной из самых популярных баз данных NoSQL, используемых в самых разных контекстах. Часто он используется в качестве кэша поверх реляционной базы данных.

Примечание: Хотя Redis хранит все свои данные в энергозависимой памяти, что делает его чрезвычайно быстрым, сервер оснащен множеством из вариантов сохранения. Они могут обеспечить различные уровни надежности данных в случае отключения питания или перезагрузки. Однако правильная настройка Redis часто оказывается сложной задачей, поэтому многие команды решают использовать управляемый сервис, переданный на аутсорсинг облачным провайдерам.

Установка Redis на ваш компьютер довольно проста, но запустить ее через Docker еще проще и элегантнее, при условии, что вы уже устанавливали и настраивали Docker ранее. Когда вы запускаете службу, такую как Redis, в контейнере Docker, она остается изолированной от остальной части вашей системы, не создавая помех и не перегружая системные ресурсы, такие как номера сетевых портов, которые ограничены.

Чтобы запустить Redis, не устанавливая его на свой хост-компьютер, вы можете запустить новый контейнер Docker из официального образа Redis, выполнив следующую команду:

$ docker run -d --name redis-server redis

Unable to find image 'redis:latest' locally

latest: Pulling from library/redis

26c5c85e47da: Pull complete

39f79586dcf2: Pull complete

79c71d0520e5: Pull complete

60e988668ca1: Pull complete

873c3fc9fdc6: Pull complete

50ce7f9bf183: Pull complete

Digest: sha256:f50031a49f41e493087fb95f96fdb3523bb25dcf6a3f0b07c588ad3cdb...

Status: Downloaded newer image for redis:latest

09b9842463c78a2e9135add810aba6c4573fb9e2155652a15310009632c40ea8

При этом создается новый контейнер Docker на основе последней версии образа redis с пользовательским именем redis-server, к которому вы будете обращаться позже. Контейнер работает в фоновом режиме в автономном режиме (-d). Когда вы запустите эту команду в первый раз, Docker извлекет соответствующий образ Docker из Docker Hub, который является официальным хранилищем образов Docker, похожим на PyPI.

Пока все идет по плану, ваш Redis-сервер должен быть запущен. Потому что вы запустили контейнер в автономном режиме (-d), он будет оставаться активным в фоновом режиме. Чтобы убедиться в этом, вы можете перечислить свои контейнеры Docker, используя команду docker container ls или эквивалентный псевдоним docker ps:

$ docker ps

CONTAINER ID IMAGE ... STATUS PORTS NAMES

09b9842463c7 redis ... Up About a minute 6379/tcp redis-server

Здесь вы можете видеть, что контейнер с префиксом ID, соответствующим тому, который вы получили при выполнении команды docker run, был запущен примерно минуту назад. Контейнер основан на образе redis, имеет имя redis-server и использует номер TCP-порта 6379, который является портом по умолчанию для Redis.

Далее вы попробуете подключиться к этому серверу Redis различными способами.

Проверьте подключение к Redis

На странице обзора официального образа Redis на Docker Hub вы найдете инструкции о том, как подключиться к серверу Redis, работающему в контейнере Docker. В частности, на этой странице рассказывается об использовании специального интерактивного интерфейса командной строки, Redis CLI, который поставляется с вашим образом Docker.

Вы можете запустить другой контейнер Docker из того же образа redis, но на этот раз задайте для точки входа контейнера команду redis-cli вместо двоичного файла сервера Redis по умолчанию. Когда вы настраиваете несколько контейнеров для совместной работы, вам следует использовать Docker networks, для настройки которых требуется выполнить несколько дополнительных шагов.

Сначала создайте новую пользовательскую мостовую сеть, названную в честь вашего проекта, например:

$ docker network create page-tracker-network

c942131265bf097da294edbd2ac375cd5410d6f0d87e250041827c68a3197684

Определив виртуальную сеть, подобную этой, вы можете подключить столько контейнеров Docker, сколько захотите, и позволить им находить друг друга с помощью описательных имен. Вы можете перечислить сети, которые вы создали, выполнив следующую команду:

$ docker network ls

NETWORK ID NAME DRIVER SCOPE

1bf8d998500e bridge bridge local

d5cffd6ea76f host host local

a85d88fc3abe none null local

c942131265bf page-tracker-network bridge local

Затем подключите существующий контейнер redis-server к этой новой виртуальной сети и укажите ту же сеть для командной строки Redis при запуске соответствующего контейнера:

$ docker network connect page-tracker-network redis-server

$ docker run --rm -it \

--name redis-client \

--network page-tracker-network \

redis redis-cli -h redis-server

Флаг --rm указывает Docker удалить созданный контейнер, как только вы его завершите, поскольку это временный или недолговечный контейнер, который вам больше не нужно запускать. Флаги -i и -t, сокращенно обозначаемые как -it, запускают контейнер в интерактивном режиме, позволяя вам вводить команды, подключаясь к стандартным потокам вашего терминала. Используя опцию --name, вы присваиваете своему новому контейнеру описательное имя.

Опция --network подключает ваш новый контейнер redis-client к ранее созданной виртуальной сети, позволяя ему взаимодействовать с контейнером redis-server. Таким образом, оба контейнера получат имен хостов, соответствующие их именам, заданным параметром --name. Обратите внимание, что, используя параметр -h, вы указываете командной строке Redis подключиться к серверу Redis, идентифицируемому по имени контейнера.

Примечание: Существует еще более быстрый способ соединить два ваших контейнера через виртуальную сеть, не создавая ее явно. Вы можете указать параметр --link при запуске нового контейнера:

$ docker run --rm -it \

--name redis-client \

--link redis-server:redis-client \

redis redis-cli -h redis-server

Однако этот параметр устарел и в какой-то момент может быть удален из Docker.

При запуске вашего нового контейнера Docker вы попадете в интерактивный интерфейс командной строки Redis, который напоминает Python REPL со следующим приглашением:

redis-server:6379> SET pi 3.14

OK

redis-server:6379> GET pi

"3.14"

redis-server:6379> DEL pi

(integer) 1

redis-server:6379> KEYS *

(empty array)

После этого вы можете протестировать несколько команд Redis, например, установив пару ключ-значение, получив значение соответствующего ключа, удалив эту пару ключ-значение или восстановив список всех ключей, хранящихся в данный момент на сервере. Чтобы выйти из интерактивного интерфейса командной строки Redis, нажмите Ctrl+C на клавиатуре.

Если вы установили Docker Desktop, то в большинстве случаев он не будет перенаправлять трафик с вашего хост-компьютера на контейнеры. Между вашей локальной сетью и сетью Docker по умолчанию не будет соединения:

Docker Desktop для Mac не может перенаправлять трафик в контейнеры. (Источник)

Docker Desktop для Windows не может перенаправлять трафик в контейнеры Linux. Однако вы можете пропинговать контейнеры Windows. (Источник)

То же самое верно и для Docker Desktop в Linux. С другой стороны, если вы используете Docker Engine или запускаете контейнеры Windows на компьютере с Windows-хостом, вы сможете получить доступ к таким контейнерам по их IP-адресам.

Таким образом, иногда у вас может быть возможность связаться с сервером Redis непосредственно с вашего хост-компьютера. Сначала узнайте IP-адрес соответствующего контейнера Docker:

$ docker inspect redis-server \

-f '{{range .NetworkSettings.Networks}}{{.IPAddress}}{{println}}{{end}}'

172.17.0.2

172.18.0.2

Если вы видите более одного IP-адреса, это означает, что ваш контейнер подключен к нескольким сетям. Контейнеры автоматически подключаются к сети Docker по умолчанию при запуске.

Обратите внимание на один из этих адресов, который может у вас отличаться. Теперь вы можете использовать этот IP-адрес в качестве значения параметра -h вместо связанного имени контейнера в redis-cli. Вы также можете использовать этот IP-адрес для подключения к Redis с помощью netcat или клиента Telnet, например, Замазка или команда telnet:

$ telnet 172.17.0.2 6379

Trying 172.17.0.2...

Connected to 172.17.0.2.

Escape character is '^]'.

SET pi 3.14

+OK

GET pi

$4

3.14

DEL pi

:1

KEYS *

*0

^]

telnet> Connection closed.

Не забудьте указать номер порта, который по умолчанию равен 6379, на котором Redis прослушивает входящие соединения. Здесь вы можете вводить команды Redis открытым текстом, поскольку сервер использует незашифрованный протокол, если вы явно не включите поддержку TLS в конфигурации.

Наконец, вы можете воспользоваться сопоставлением портов, чтобы сделать Redis доступным за пределами контейнера Docker. Во время разработки вы захотите подключиться к Redis напрямую, а не через виртуальную сеть из другого контейнера, поэтому вам пока не нужно подключать его к какой-либо сети.

Чтобы использовать сопоставление портов, остановите и удалите существующий redis-server, а затем запустите новый контейнер с параметром -p, указанным ниже:

$ docker stop redis-server

$ docker rm redis-server

$ docker run -d --name redis-server -p 6379:6379 redis

Число слева от двоеточия (:) обозначает номер порта на главном компьютере или на вашем компьютере, в то время как число справа обозначает подключенный порт внутри контейнера Docker, который должен быть запущен. Использование одного и того же номера порта с обеих сторон эффективно перенаправляет его, так что вы можете подключиться к Redis так, как если бы он был запущен локально на вашем компьютере:

$ telnet localhost 6379

Trying 127.0.0.1...

Connected to localhost.

Escape character is '^]'.

INCR page_views

:1

INCR page_views

:2

INCR page_views

:3

^]

telnet> Connection closed.

После подключения к Redis, которое теперь отображается на локальном хосте и на порту по умолчанию, вы используете команду INCR, чтобы увеличить количество просмотров страниц. Если базовый ключ еще не существует, то Redis инициализирует его значением 1.

Примечание: Если у вас локально установлен Redis или какой-либо системный процесс также использует порт 6379 на вашем хост-компьютере, вам нужно будет по-другому сопоставить номера ваших портов используя незанятый порт. Например, вы могли бы сделать следующее:

$ docker run -d --name redis-server -p 9736:6379 redis

Это позволит вам подключиться к localhost через порт 9736, если он еще не занят другой службой. Неважно, какой порт вы используете, главное, чтобы он был доступен.

Теперь, когда вы знаете, как подключиться к Redis из командной строки, вы можете двигаться дальше и посмотреть, как сделать то же самое с помощью программы на Python.

Подключение к Redis из Python

На данный момент у вас есть сервер Redis, работающий в контейнере Docker, доступ к которому вы можете получить на локальном хостинге, используя номер порта Redis по умолчанию. Если вы хотите узнать больше о своем контейнере или любом другом ресурсе Docker, вы всегда можете получить ценную информацию, просмотрев объект, который находится под рукой:

$ docker inspect redis-server

[

{

"Id": "09b9842463c78a2e9135add810aba6...2a15310009632c40ea8",

⋮

"NetworkSettings": {

⋮

"Ports": {

"6379/tcp": null

},

⋮

"IPAddress": "172.17.0.2",

⋮

}

}

]

В данном случае вы запрашиваете информацию о контейнере redis-server, которая включает в себя множество деталей, таких как конфигурация сети контейнера. Команда docker inspect по умолчанию возвращает данные в формате JSON, которые вы можете дополнительно отфильтровать, используя шаблоны Go.

Затем откройте терминал, активируйте виртуальную среду вашего проекта и запустите новый Python REPL:

S> venv\Scripts\activate

(page-tracker) PS> python

$ source venv/bin/activate

(page-tracker) $ python

Предполагая, что вы ранее установили пакет redis в этой виртуальной среде, вы должны иметь возможность импортировать клиент Redis для Python и вызвать один из его методов:

>>> from redis import Redis

>>> redis = Redis()

>>> redis.incr("page_views")

4

>>> redis.incr("page_views")

5

Когда вы создаете новый экземпляр Redis без указания каких-либо аргументов, он попытается подключиться к серверу Redis, работающему на локальном хосте, и порту по умолчанию 6379. В этом случае вызов .incr() подтверждает, что вы успешно установили соединение с Redis, находящимся в вашем контейнере Docker, поскольку он запомнил последнее значение ключа page_views.

Если вам нужно подключиться к Redis, расположенному на удаленном компьютере, укажите пользовательский хост и номер порта в качестве параметров:

>>> from redis import Redis

>>> redis = Redis(host="127.0.0.1", port=6379)

>>> redis.incr("page_views")

6

Обратите внимание, что вы должны передавать номер порта как целое число, хотя библиотека не будет возражать, если вы передадите строку вместо этого.

Другим способом подключения к Redis является использование специально отформатированной строки, которая представляет собой URL-адрес:

>>> from redis import Redis

>>> redis = Redis.from_url("redis://localhost:6379/")

>>> redis.incr("page_views")

7

Это может быть особенно удобно, если вы хотите сохранить конфигурацию Redis в файле или переменной среды.

Отлично! Вы можете использовать один из этих фрагментов кода и интегрировать его в свое веб-приложение Flask. В следующем разделе вы увидите, как это сделать.

Внедрить и запустить приложение Flask локально

Вернитесь в свой редактор кода, откройте модуль app в вашем проекте page-tracker и напишите следующие несколько строк кода на Python:

# src/page_tracker/app.py

from flask import Flask

from redis import Redis

app = Flask(__name__)

redis = Redis()

@app.get("/")

def index():

page_views = redis.incr("page_views")

return f"This page has been seen {page_views} times."

Вы начинаете с импорта Flask и Redis из соответствующих сторонних библиотек вашего проекта, перечисленных в качестве зависимостей. Затем вы создаете экземпляр приложения Flask и клиент Redis, используя аргументы по умолчанию, что означает, что клиент попытается подключиться к локальному серверу Redis. Наконец, вы определяете функцию контроллера для обработки запросов HTTP GET, поступающих на корневой адрес веб-сервера (/).

Ваша конечная точка увеличивает количество просмотров страниц в Redis и отображает соответствующее сообщение в веб-браузере клиента. Вот и все! У вас есть полноценное веб-приложение, которое может обрабатывать HTTP-трафик и сохранять состояние в удаленном хранилище данных, используя менее десяти строк кода.

Чтобы проверить, работает ли ваше приложение Flask должным образом, выполните следующую команду в терминале:

(page-tracker) $ flask --app page_tracker.app run

* Serving Flask app 'page_tracker.app'

* Debug mode: off

WARNING: This is a development server. Do not use it in a production

⮑ deployment. Use a production WSGI server instead.

* Running on http://127.0.0.1:5000

Press CTRL+C to quit

Вы можете запустить эту команду в любом месте вашей файловой системы, если вы активировали правильную виртуальную среду и установили свой пакет page-tracker. При этом должен быть запущен Сервер разработки Flask на локальном хосте и порту 5000 с отключенным режимом отладки.

Если вы хотите получить доступ к своему серверу с другого компьютера в той же сети, вы должны привязать его ко всем сетевым интерфейсам, используя специальный адрес 0.0.0.0 вместо локальный хост по умолчанию, который представляет интерфейс обратной связи:

(page-tracker) $ flask --app page_tracker.app run --host=0.0.0.0 \

--port=8080 \

--debug

* Serving Flask app 'page_tracker.app'

* Debug mode: on

WARNING: This is a development server. Do not use it in a production

⮑ deployment. Use a production WSGI server instead.

* Running on all addresses (0.0.0.0)

* Running on http://127.0.0.1:8080

* Running on http://192.168.0.115:8080

Press CTRL+C to quit

* Restarting with stat

* Debugger is active!

* Debugger PIN: 123-167-546

Вы также можете изменить номер порта и включить режим отладки с помощью соответствующей опции командной строки или флажка, если хотите.

После запуска сервера вы можете перейти по ссылке, отображаемой в терминале, и просмотреть страницу с количеством просмотров в вашем веб-браузере. Каждый раз, когда вы обновляете эту страницу, счетчик должен увеличиваться на единицу.

Отличная работа! Вам удалось создать простое приложение Flask, которое отслеживает количество просмотров страниц с помощью Redis. Далее вы узнаете, как протестировать и обезопасить свое веб-приложение.

Протестируйте и обезопасьте свое веб-приложение

Перед упаковкой и развертыванием любого проекта в рабочей среде вы должны тщательно протестировать, изучить и обезопасить исходный код, лежащий в его основе. В этой части руководства вы будете выполнять модульные, интеграционные и комплексные тесты. Вы также выполните статический анализ кода и сканирование системы безопасности для выявления потенциальных проблем и уязвимостей, когда их еще можно легко устранить.

Покройте Исходный Код модульными тестами

Модульное тестирование включает в себя тестирование отдельных модулей программы или компонентов чтобы убедиться, что они работают должным образом. В наши дни это стало необходимой частью разработки программного обеспечения. Многие инженеры идут еще дальше, строго следуя методологии разработки, основанной на тестировании, и сначала пишут свои модульные тесты, которые определяют дизайн кода.

Когда дело доходит до написания модульных тестов, те, кто работает на Python, довольно часто выбирают pytest вместо модуля стандартной библиотеки unittest . Благодаря относительной простоте pytest, с этим фреймворком тестирования можно быстро начать. Продолжайте и добавьте pytest в качестве необязательной зависимости к вашему проекту:

# pyproject.toml

[build-system]

requires = ["setuptools>=67.0.0", "wheel"]

build-backend = "setuptools.build_meta"

[project]

name = "page-tracker"

version = "1.0.0"

dependencies = [

"Flask",

"redis",

]

[project.optional-dependencies]

dev = [

"pytest",

]

Вы можете сгруппировать необязательные зависимости, которые каким-то образом связаны под общим названием. Здесь, например, вы создали группу под названием dev для сбора инструментов и библиотек, которые вы будете использовать в процессе разработки. Сохраняя pytest отдельно от основных зависимостей, вы сможете устанавливать ее по требованию только при необходимости. В конце концов, нет смысла связывать ваши тесты или связанный с ними фреймворк тестирования со встроенным дистрибутивом .

Не забудьте переустановить свой пакет Python с дополнительными зависимостями, чтобы получить pytest в виртуальной среде вашего проекта:

(page-tracker) $ python -m pip install --editable ".[dev]"

Вы можете использовать квадратные скобки для перечисления имен необязательных групп зависимостей, определенных в вашем файле pyproject.toml. В этом случае вы запрашиваете установку зависимостей для целей разработки, включая платформу тестирования. Обратите внимание, что рекомендуется заключать квадратные скобки в кавычки (""), чтобы предотвратить возможное расширение имени файла в командной строке.

Поскольку в вашем проекте вы следовали схеме src, вам не нужно хранить тестовые модули ни в той же папке, ни в том же пакете пространства имен, что и ваш тестируемый код. Вы можете создать отдельную ветку каталога для своих тестов следующим образом:

page-tracker/

│

├── src/

│ └── page_tracker/

│ ├── __init__.py

│ └── app.py

│

├── test/

│ └── unit/

│ └── test_app.py

│

├── venv/

│

├── constraints.txt

└── pyproject.toml

Вы поместили свой тестовый модуль в папку test/unit/, чтобы все было упорядочено. Платформа pytest обнаружит ваши тесты, если вы добавите к ним слово test. Хотя вы можете изменить это, обычно соблюдается соглашение по умолчанию при зеркальном отображении каждого модуля Python с соответствующим тестовым модулем. Например, вы закроете модуль app с помощью test_app в своей папке test/unit/.

Вы начнете с тестирования оптимального пути вашего веб-приложения, что обычно означает отправку запроса на сервер. Каждое приложение Flask поставляется с удобным тестовым клиентом, который вы можете использовать для создания имитируемых HTTP-запросов. Поскольку для тестового клиента не требуется работающий сервер, ваши модульные тесты будут выполняться намного быстрее и станут более изолированными.

Вы можете получить тестовый клиент и удобно поместить его в тестовое устройство, чтобы сделать его доступным для ваших тестовых функций:

# test/unit/test_app.py

import pytest

from page_tracker.app import app

@pytest.fixture

def http_client():

return app.test_client()

Сначала вы импортируете пакет pytest, чтобы воспользоваться преимуществами его @fixture декоратор для вашей пользовательской функции. Тщательно выбирайте имя вашей функции, потому что оно также станет именем устройства, которое вы сможете передавать в качестве аргумента отдельным тестовым функциям. Вы также импортируете приложение Flask из своего пакета page_tracker, чтобы получить соответствующий экземпляр тестового клиента.

Когда вы собираетесь написать модульный тест, вы всегда должны изолировать его, устраняя любые зависимости, которые могут быть у вашего модуля кода. Это означает, что вам следует имитировать или отключить любые внешние службы, базы данных или библиотеки, на которые опирается ваш код. В вашем случае такой зависимостью является сервер Redis.

К сожалению, в вашем коде в настоящее время используется жестко запрограммированный клиент Redis, который предотвращает насмешки. Это хороший аргумент в пользу того, чтобы с самого начала использовать разработку на основе тестирования, но это не значит, что вам нужно возвращаться и начинать все сначала. Вместо этого вы собираетесь реорганизовать свой код, реализовав внедрение зависимостей шаблон проектирования:

# src/page_tracker/app.py

+from functools import cache

from flask import Flask

from redis import Redis

app = Flask(__name__)

-redis = Redis()

@app.get("/")

def index():

- page_views = redis.incr("page_views")

+ page_views = redis().incr("page_views")

return f"This page has been seen {page_views} times."

+@cache

+def redis():

+ return Redis()

По сути, вы перемещаете код создания клиента Redis из глобальной области в новую redis() функцию, которую функция вашего контроллера вызывает во время выполнения при каждом входящем запросе. Это позволит вашему тестовому набору в нужный момент заменить возвращенный экземпляр Redis имитационным аналогом. Но, чтобы гарантировать, что в памяти есть только один экземпляр клиента, фактически превращая его в одноэлементный, вы также кэшируете результат вашей новой функции.

Теперь вернитесь к своему тестовому модулю и выполните следующий модульный тест:

# test/unit/test_app.py

import unittest.mock

import pytest

from page_tracker.app import app

@pytest.fixture

def http_client():

return app.test_client()

@unittest.mock.patch("page_tracker.app.redis")

def test_should_call_redis_incr(mock_redis, http_client):

# Given

mock_redis.return_value.incr.return_value = 5

# When

response = http_client.get("/")

# Then

assert response.status_code == 200

assert response.text == "This page has been seen 5 times."

mock_redis.return_value.incr.assert_called_once_with("page_views")

Вы обертываете свою тестовую функцию с помощью Python's @patch decorator, чтобы ввести в нее имитируемый клиент Redis в качестве аргумента. Вы также указываете pytest, чтобы ввести свой HTTP-тестовый клиентский инструмент в качестве еще одного аргумента. Тестовая функция имеет описательное название, которое начинается с глагола should и следует шаблону Given-When-Then. Оба этих соглашения, обычно используемые в разработке, основанной на поведении, позволяют интерпретировать ваш тест как поведенческие спецификации.

В вашем тестовом примере вы сначала настраиваете макетный клиент Redis так, чтобы он всегда возвращал 5 всякий раз, когда вызывается его метод .incr(). Затем вы отправляете поддельный HTTP-запрос к корневой конечной точке (/) и проверяете статус ответа сервера и тело. Поскольку mocking помогает вам протестировать поведение вашего модуля, вы только проверяете, что сервер вызывает правильный метод с ожидаемым аргументом, полагаясь на то, что клиентская библиотека Redis работает правильно.

Для выполнения модульных тестов вы можете либо использовать средство запуска тестов, встроенное в ваш редактор кода, либо ввести следующую команду в терминале:

(page-tracker) $ python -m pytest -v test/unit/

Вы запускаете pytest как модуль Python из своей виртуальной среды, проинструктировав его сканировать каталог test/unit/, чтобы найти там тестовые модули. Переключатель -v увеличивает детализацию отчета о тестировании, так что вы можете увидеть более подробную информацию об отдельных тестовых примерах.

Просмотр зеленого отчета после прохождения всех ваших модульных тестов может принести удовлетворение. Это дает вам некоторую уверенность в вашем коде, но вряд ли этого достаточно, чтобы давать какие-либо гарантии. Множество мемов иллюстрируют важность выполнения интеграционных тестов даже после завершения модульных тестов.

Например, на одном из классических мемов изображены два ящика, но одновременно может открываться только один. Хотя каждый отдельный выдвижной ящик или модуль был протестирован и работает сам по себе, проблемы возникают, когда вы пытаетесь интегрировать их в предмет мебели. Далее вы добавите в свой проект элементарный интеграционный тест.

Проверьте взаимодействие Компонентов С Помощью Интеграционных Тестов

Интеграционное тестирование должно стать следующим этапом после выполнения модульных тестов. Цель интеграционного тестирования - проверить, как ваши компоненты взаимодействуют друг с другом как части более крупной системы. Например, в вашем веб-приложении для отслеживания страниц могут быть интеграционные тесты, которые проверяют связь с подлинным сервером Redis, а не с поддельным.

Вы можете повторно использовать pytest для реализации и запуска интеграционных тестов. Однако вы установите дополнительный pytest-timeout плагин, который позволит вам принудительно завершать работу с тестовыми примерами, выполнение которых занимает слишком много времени:

# pyproject.toml

[build-system]

requires = ["setuptools>=67.0.0", "wheel"]

build-backend = "setuptools.build_meta"

[project]

name = "page-tracker"

version = "1.0.0"

dependencies = [

"Flask",

"redis",

]

[project.optional-dependencies]

dev = [

"pytest",

"pytest-timeout",

]

В идеале вам не нужно беспокоиться о тайминге модульных тестов, потому что они должны быть оптимизированы для повышения скорости. С другой стороны, выполнение интеграционных тестов займет больше времени, и они могут бесконечно зависать из-за сбоя сетевого подключения, что не позволит завершить выполнение вашего набора тестов . Поэтому важно иметь возможность прервать их в подобных случаях.

Не забудьте переустановить свой пакет с дополнительными зависимостями еще раз, чтобы сделать доступным плагин pytest-timeout:

(page-tracker) $ python -m pip install --editable ".[dev]"

Прежде чем двигаться дальше, добавьте еще одну вложенную папку для ваших интеграционных тестов и укажите файл conftest.py в вашей папке test/:

page-tracker/

│

├── src/

│ └── page_tracker/

│ ├── __init__.py

│ └── app.py

│

├── test/

│ ├── integration/

│ │ └── test_app_redis.py

│ │

│ ├── unit/

│ │ └── test_app.py

│ │

│ └── conftest.py

│

├── venv/

│

├── constraints.txt

└── pyproject.toml

В conftest.py вы разместите общие параметры, которые будут использоваться разными типами тестов совместно.

Хотя в вашем веб-приложении есть только один компонент, вы можете рассматривать Redis как еще один компонент, с которым должен работать Flask. Таким образом, интеграционный тест может выглядеть аналогично вашему модульному тесту, за исключением того, что клиент Redis больше не будет подвергаться издевательствам:

# test/integration/test_app_redis.py

import pytest

@pytest.mark.timeout(1.5)

def test_should_update_redis(redis_client, http_client):

# Given

redis_client.set("page_views", 4)

# When

response = http_client.get("/")

# Then

assert response.status_code == 200

assert response.text == "This page has been seen 5 times."

assert redis_client.get("page_views") == b"5"

Концептуально ваш новый тестовый пример состоит из тех же шагов, что и предыдущий, но он взаимодействует с реальным сервером Redis. Вот почему вы даете тесту не более 1.5 секунд на завершение с помощью декоратора @pytest.mark.timeout. Функция тестирования принимает в качестве параметров два параметра:

- Клиент Redis, подключенный к локальному хранилищу данных

- Тестовый клиент Flask, подключенный к вашему веб-приложению

Чтобы сделать доступным и второй модуль в вашем интеграционном тесте, вы должны переместить модуль http_client() из модуля test_app в файл conftest.py:

# test/conftest.py

import pytest

import redis

from page_tracker.app import app

@pytest.fixture

def http_client():

return app.test_client()

@pytest.fixture(scope="module")

def redis_client():

return redis.Redis()

Поскольку этот файл расположен на один уровень выше в иерархии папок, pytest подберет все параметры, определенные в нем, и сделает их видимыми во всех ваших вложенных папках. Помимо знакомого http_client() fixture, который вы перенесли из другого модуля Python, вы определяете новый fixture, который возвращает клиент Redis по умолчанию. Обратите внимание, что вы предоставляете ему область действия module для повторного использования одного и того же экземпляра клиента Redis для всех функций в тестовом модуле.

Чтобы выполнить интеграционный тест, вам нужно будет дважды проверить, запущен ли сервер Redis локально на порту по умолчанию 6379, а затем запустить pytest как и раньше, но указать на папку с ваши интеграционные тесты:

(page-tracker) $ python -m pytest -v test/integration/

Поскольку ваш интеграционный тест подключается к реальному серверу Redis, он перезапишет значение, которое вы, возможно, ранее сохранили под ключом page_views. Однако, если сервер Redis не запущен во время выполнения ваших интеграционных тестов или если Redis запущен в другом месте, то ваш тест завершится неудачей. Этот сбой может быть вызван неправильными причинами, что приводит к ложноотрицательной ошибке, поскольку ваш код на самом деле может работать так, как ожидалось.

Чтобы устранить эту проблему, остановите Redis сейчас и повторно запустите интеграционный тест:

(page-tracker) $ docker stop redis-server

redis-server

(page-tracker) $ python -m pytest -v test/integration/

⋮

========================= short test summary info ==========================

FAILED test/integration/test_app_redis.py::test_should_update_redis -

⮑redis.exceptions.ConnectionError: Error 111 connecting to localhost:6379.

⮑Connection refused

============================ 1 failed in 0.19s =============================

Это выявляет проблему в вашем коде, которая на данный момент не позволяет корректно обрабатывать ошибки подключения к Redis. В духе разработки, основанной на тестировании, вы можете сначала кодифицировать тестовый пример, который воспроизводит эту проблему, а затем устранить ее. Переключитесь на мгновение и добавьте следующий модуль тестирования в свой test_app модуль с имитацией клиента Redis:

# test/unit/test_app.py

import unittest.mock

from redis import ConnectionError

# ...

@unittest.mock.patch("page_tracker.app.redis")

def test_should_handle_redis_connection_error(mock_redis, http_client):

# Given

mock_redis.return_value.incr.side_effect = ConnectionError

# When

response = http_client.get("/")

# Then

assert response.status_code == 500

assert response.text == "Sorry, something went wrong \N{pensive face}"

Вы задаете имитируемый .incr() побочный эффект метода, чтобы при вызове этого метода возникало исключение redis.ConnectionError , который вы наблюдали, когда интеграционный тест завершился неудачей. Ваш новый модульный тест, который является примером отрицательного теста, ожидает, что Flask ответит кодом состояния HTTP 500 и описательным сообщением. Вот как вы можете выполнить этот модульный тест:

# src/page_tracker/app.py

from functools import cache

from flask import Flask

from redis import Redis, RedisError

app = Flask(__name__)

@app.get("/")

def index():

try:

page_views = redis().incr("page_views")

except RedisError:

app.logger.exception("Redis error")

return "Sorry, something went wrong \N{pensive face}", 500

else:

return f"This page has been seen {page_views} times."

@cache

def redis():

return Redis()

Вы перехватываете класс исключений верхнего уровня, redis.RedisError, который является предком всех типов исключений, создаваемых клиентом Redis. Если что-то пойдет не так, вы вернете ожидаемый код состояния HTTP и сообщение. Для удобства вы также регистрируете исключение с помощью регистратора, встроенного в Flask.

Примечание: В то время как родительский класс является непосредственным базовым классом, который непосредственно расширяется дочерним классом, предок может находиться где угодно выше по иерархии наследования.

Отлично! Благодаря тестированию вы внесли изменения в свои модульные тесты, внедрили интеграционный тест и исправили дефект в коде после того, как узнали о нем. Тем не менее, когда вы развертываете свое приложение в удаленной среде, как вы узнаете, что все компоненты подходят друг к другу и все работает так, как ожидалось?

В следующем разделе вы смоделируете реальный сценарий, выполнив сквозной тест на вашем реальном сервере Flask, а не на тестовом клиенте.

Протестируйте реальный сценарий от начала до конца (E2E)

Комплексное тестирование, также известное как тестирование широкого стека, включает в себя множество видов тестов, которые могут помочь вам проверить систему в целом. Они протестировали весь программный стек, смоделировав работу реального пользователя с приложением. Таким образом, для комплексного тестирования требуется среда развертывания, максимально приближенная к производственной среде. Обычно также требуется специальная команда инженеров-тестировщиков.

Примечание: Поскольку комплексные тесты требуют больших затрат на обслуживание и, как правило, занимают много времени на настройку и запуск, они находятся на вершине пирамиды тестирования Google . Другими словами, вам следует стремиться к большему количеству интеграционных тестов и даже к большему количеству модульных тестов в ваших проектах.

Поскольку в конечном итоге вы захотите создать полноценный конвейер непрерывной интеграции для своего приложения Docker, наличие нескольких сквозных тестов станет необходимым. Начните с добавления другой подпапки для ваших тестов E2E:

page-tracker/

│

├── src/

│ └── page_tracker/

│ ├── __init__.py

│ └── app.py

│

├── test/

│ ├── e2e/

│ │ └── test_app_redis_http.py

│ │

│ ├── integration/

│ │ └── test_app_redis.py

│ │

│ ├── unit/

│ │ └── test_app.py

│ │

│ └── conftest.py

│

├── venv/

│

├── constraints.txt

└── pyproject.toml

Тестовый сценарий, который вы собираетесь реализовать, будет похож на ваш интеграционный тест. Однако основное отличие заключается в том, что вы будете отправлять фактический HTTP-запрос через сеть на веб-сервер в реальном времени, а не полагаться на тестовый клиент Flask. Для этого вы будете использовать стороннюю библиотеку requests, которую вы должны сначала указать в своем файле pyproject.toml в качестве еще одной необязательной зависимости:

# pyproject.toml

[build-system]

requires = ["setuptools>=67.0.0", "wheel"]

build-backend = "setuptools.build_meta"

[project]

name = "page-tracker"

version = "1.0.0"

dependencies = [

"Flask",

"redis",

]

[project.optional-dependencies]

dev = [

"pytest",

"pytest-timeout",

"requests",

]

Вы не будете использовать requests для запуска вашего сервера в рабочей среде, поэтому нет необходимости требовать его в качестве обычной зависимости. Снова переустановите свой пакет Python с дополнительными зависимостями, используя редактируемый режим:

(page-tracker) $ python -m pip install --editable ".[dev]"

Теперь вы можете использовать установленную библиотеку requests в своем комплексном тестировании:

1# test/e2e/test_app_redis_http.py

2

3import pytest

4import requests

5

6@pytest.mark.timeout(1.5)

7def test_should_update_redis(redis_client, flask_url):

8 # Given

9 redis_client.set("page_views", 4)

10

11 # When

12 response = requests.get(flask_url)

13

14 # Then

15 assert response.status_code == 200

16 assert response.text == "This page has been seen 5 times."

17 assert redis_client.get("page_views") == b"5"

Этот код практически идентичен вашему интеграционному тесту, за исключением строки 12, которая отвечает за отправку HTTP-запроса GET. Ранее вы отправляли этот запрос на корневой адрес тестового клиента, обозначенный символом косой черты (/). Теперь вы не знаете точный домен или IP-адрес сервера Flask, который, возможно, запущен на удаленном хосте. Следовательно, ваша функция получает URL-адрес Flask в качестве аргумента, который pytest вводится как фиксированный.

Вы можете указать адрес конкретного веб-сервера через командную строку. Аналогично, ваш сервер Redis может быть запущен на другом хостинге, поэтому вам также потребуется указать его адрес в качестве аргумента командной строки . Но подождите! В настоящее время ваше приложение Flask ожидает, что Redis всегда будет запускаться на локальном хостинге. Продолжайте и обновите свой код, чтобы сделать это настраиваемым:

# src/page_tracker/app.py

import os

from functools import cache

from flask import Flask

from redis import Redis, RedisError

app = Flask(__name__)

@app.get("/")

def index():

try:

page_views = redis().incr("page_views")

except RedisError:

app.logger.exception("Redis error")

return "Sorry, something went wrong \N{pensive face}", 500

else:

return f"This page has been seen {page_views} times."

@cache

def redis():

return Redis.from_url(os.getenv("REDIS_URL", "redis://localhost:6379"))

Обычно используется переменные среды для настройки конфиденциальных данных, таких как URL базы данных, поскольку это обеспечивает дополнительный уровень безопасности и гибкости. В этом случае ваша программа ожидает, что будет существовать пользовательская переменная REDIS_URL. Если эта переменная не указана в данной среде, вы возвращаетесь к хосту и порту по умолчанию.

Чтобы расширить pytest с помощью пользовательских аргументов командной строки, вы должны отредактировать conftest.py и подключиться к анализатору аргументов фреймворка следующим образом:

# test/conftest.py

import pytest

import redis

from page_tracker.app import app

def pytest_addoption(parser):

parser.addoption("--flask-url")

parser.addoption("--redis-url")

@pytest.fixture(scope="session")

def flask_url(request):

return request.config.getoption("--flask-url")

@pytest.fixture(scope="session")

def redis_url(request):

return request.config.getoption("--redis-url")

@pytest.fixture

def http_client():

return app.test_client()

@pytest.fixture(scope="module")

def redis_client(redis_url):

if redis_url:

return redis.Redis.from_url(redis_url)

return redis.Redis()

Вы определяете два необязательных аргумента, --flask-url и --redis-url, используя синтаксис, аналогичный модулю Python argparse. Затем вы помещаете эти аргументы в фиксированных параметров сеанса, которые вы сможете внедрять в свои тестовые функции и другие фиксированные параметры. В частности, ваше существующее приложение redis_client() теперь использует дополнительный URL-адрес Redis.

Примечание: Поскольку в ваших сквозных тестах и интеграционных тестах используется одно и то же устройство redis_client(), вы сможете подключиться к удаленному серверу Redis, указав параметр --redis-url в обоих типах тестов.

Вот как вы можете запустить свой сквозной тест с помощью pytest, указав URL-адрес веб-сервера Flask и соответствующего сервера Redis:

(page-tracker) $ python -m pytest -v test/e2e/ \

--flask-url http://127.0.0.1:5000 \

--redis-url redis://127.0.0.1:6379

В этом случае вы можете получить доступ как к Flask, так и к Redis через localhost (127.0.0.1), но ваше приложение может быть развернуто в географически распределенной среде, состоящей из нескольких удаленных компьютеров. Когда вы будете выполнять эту команду локально, убедитесь, что Redis запущен, и сначала запустите свой сервер Flask отдельно:

(page-tracker) $ docker start redis-server

(page-tracker) $ flask --app page_tracker.app run

Чтобы улучшить качество кода, вы можете добавлять в свое приложение дополнительные типы тестов, если у вас есть возможность. Тем не менее, для этого обычно требуется команда инженеров, работающих полный рабочий день по обеспечению качества программного обеспечения. С другой стороны, выполнение проверки кода или другого типа статического анализа кода - это довольно малозначительный результат, который может выявить удивительно много проблем. Сейчас вы познакомитесь с этим процессом.

Выполнить статический анализ кода и проверку безопасности

Теперь, когда ваше приложение работает должным образом, пришло время выполнить статический анализ кода без выполнения базового кода. Это распространенная практика в индустрии разработки программного обеспечения, которая помогает разработчикам выявлять потенциальные программные дефекты и угрозы безопасности в их коде. В то время как некоторые этапы статического анализа могут быть автоматизированы, другие обычно выполняются вручную, например, с помощью экспертной оценки .

Вы будете использовать следующие автоматизированные инструменты, поэтому, пожалуйста, добавьте их в свой файл pyproject.toml в качестве необязательных зависимостей:

# pyproject.toml

[build-system]

requires = ["setuptools>=67.0.0", "wheel"]

build-backend = "setuptools.build_meta"

[project]

name = "page-tracker"

version = "1.0.0"

dependencies = [

"Flask",

"redis",

]

[project.optional-dependencies]

dev = [

"bandit",

"black",

"flake8",

"isort",

"pylint",

"pytest",

"pytest-timeout",

"requests",

]

Не забудьте после этого переустановить и закрепить свои зависимости:

(page-tracker) $ python -m pip install --editable ".[dev]"

(page-tracker) $ python -m pip freeze --exclude-editable > constraints.txt

Это позволит использовать в вашей виртуальной среде несколько утилит командной строки. Прежде всего, вам следует очистить свой код, последовательно отформатировав его, отсортировав операторы import и проверив соответствие PEP 8:

(page-tracker) $ python -m black src/ --check

would reformat /home/realpython/page-tracker/src/page_tracker/app.py

Oh no! 💥 💔 💥

1 file would be reformatted, 1 file would be left unchanged.

(page-tracker) $ python -m isort src/ --check

ERROR: /home/.../app.py Imports are incorrectly sorted and/or formatted.

(page-tracker) $ python -m flake8 src/

src/page_tracker/app.py:23:1: E302 expected 2 blank lines, found 1

Используется black для обозначения любых несоответствий форматирования в вашем коде, isort для обеспечения того, чтобы ваши import инструкции были организованы в соответствии с официальными рекомендациями, и flake8 для проверки любых другие нарушения стиля PEP 8.

Если после запуска этих инструментов вы не видите никаких результатов, это означает, что исправлять нечего. С другой стороны, если появляются предупреждения или ошибки, вы можете исправить любые обнаруженные проблемы вручную или позволить этим инструментам делать это автоматически, когда вы снимаете флаг --check:

(page-tracker) $ python -m black src/

reformatted /home/realpython/page-tracker/src/page_tracker/app.py

All done! ✨ 🍰 ✨

1 file reformatted, 1 file left unchanged.

(page-tracker) $ python -m isort src/

Fixing /home/realpython/page-tracker/src/page_tracker/app.py

(page-tracker) $ python -m flake8 src/

Без флажка --check, как black, так и isort переформатируйте поврежденные файлы на месте без запроса. Выполнение этих двух команд также обеспечивает соответствие требованиям PEP 8, поскольку flake8 больше не возвращает никаких нарушений стиля.

Примечание: Полезно поддерживать порядок в коде, следуя общим правилам оформления кода в вашей команде. Таким образом, когда один человек обновляет исходный файл, членам команды не придется разбираться с изменениями в несущественных частях кода, таких как пробелы.

Как только все будет вычищено, вы можете доработать свой код, чтобы найти потенциальные запахи кода или способы их улучшения:

(page-tracker) $ python -m pylint src/

Когда вы запускаете pylint с использованием исходного кода вашего веб-приложения, оно может начать жаловаться на более или менее полезные вещи. Как правило, он отправляет сообщения, относящиеся к нескольким категориям, включая:

- E: Ошибки

- W: Предупреждения

- C: Нарушения Конвенции

- R: Предложения по рефакторингу

Каждое замечание имеет уникальный идентификатор, например C0116,, который вы можете отключить, если сочтете его бесполезным. Вы можете включить подавленные идентификаторы в глобальный конфигурационный файл для обеспечения постоянного эффекта или использовать переключатель командной строки, чтобы игнорировать определенные ошибки при выполнении. Вы также можете добавить специально отформатированный комментарий Python к данной строке для учета особых случаев:

# src/page_tracker/app.py

import os

from functools import cache

from flask import Flask

from redis import Redis, RedisError

app = Flask(__name__)

@app.get("/")

def index():

try:

page_views = redis().incr("page_views")

except RedisError:

app.logger.exception("Redis error") # pylint: disable=E1101

return "Sorry, something went wrong \N{pensive face}", 500

else:

return f"This page has been seen {page_views} times."

@cache

def redis():

return Redis.from_url(os.getenv("REDIS_URL", "redis://localhost:6379"))

В этом случае вы указываете pylint игнорировать конкретный экземпляр ошибки E1101, не подавляя ее полностью. Это ложноположительный результат, потому что .logger - это динамический атрибут, сгенерированный Flask во время выполнения, который недоступен во время прохождения статического анализа.

Примечание: Если вы собираетесь использовать pylint как часть вашего автоматизированного конвейера непрерывной интеграции, то вы можете указать, когда он должен завершиться с помощью код ошибки, который обычно останавливает последующие этапы конвейера. Например, вы можете настроить его так, чтобы он всегда возвращал нулевой нейтральный код выхода:

(page-tracker) $ python -m pylint src/ --exit-zero

Это никогда не остановит работу конвейера, даже если pylint обнаружит какие-то проблемы в коде. В качестве альтернативы, используя --fail-under, вы можете указать произвольный порог оценки, при достижении которого pylint завершится с кодом ошибки.

Вы заметите, что pylint присваивает вашему коду оценку и отслеживает ее. Когда вы устраните проблему тем или иным способом и запустите инструмент снова, он выдаст новую оценку и сообщит вам, насколько она улучшилась или ухудшилась. Руководствуйтесь здравым смыслом, чтобы решить, стоит ли устранять проблемы, о которых сообщается в pylint отчетах.

Наконец, слишком часто происходит непреднамеренная утечка конфиденциальных данных через исходный код или другие уязвимости в системе безопасности. Это случается даже с лучшими разработчиками программного обеспечения. Недавно GitHub опубликовал свой закрытый ключ в общедоступном репозитории, что могло позволить злоумышленникам выдать себя за гиганта. Чтобы снизить риск подобных инцидентов, вам следует выполнить проверку безопасности или уязвимостей исходного кода перед его развертыванием где бы то ни было.

Для проверки вашего кода вы можете использовать bandit,, который вы установили ранее в качестве дополнительной зависимости:

(page-tracker) $ python -m bandit -r src/

Когда вы указываете путь к папке, а не к файлу, вы также должны включить флаг -r для его рекурсивного сканирования. На данный момент bandit не должен обнаружить никаких проблем в вашем коде. Но если вы запустите его снова после добавления следующих двух строк в нижней части вашего приложения Flask, то инструмент сообщит о проблемах с разными уровнями серьезности:

# src/page_tracker/app.py

# ...

if __name__ == "__main__":

app.run(host="0.0.0.0", port=5000, debug=True)

Это название-основная идиома - распространенный шаблон, встречающийся во многих приложениях Flask, поскольку он делает разработку более удобной, позволяя запускать модуль Python напрямую. С другой стороны, он предоставляет доступ к отладчику Flask, позволяя выполнять произвольный код и привязываться ко всем сетевым интерфейсам через адрес 0.0.0.0 ваш сервис будет доступен для общественного транспорта.

Поэтому, чтобы убедиться в безопасности вашего приложения Flask, вам всегда следует запускать bandit или аналогичный инструмент перед развертыванием кода в рабочей среде.

Хорошо. Ваше веб-приложение проходит модульные, интеграционные и комплексные тесты. Это означает, что ряд автоматизированных инструментов статически проанализировали и модифицировали его исходный код. Далее вы продолжите путь к непрерывной интеграции, поместив приложение в контейнер Docker, чтобы можно было развернуть весь проект в удаленной среде или точно воспроизвести его на локальном компьютере.

Настройте настройки вашего веб-приложения Flask

В этом разделе вы запустите свое веб-приложение для отслеживания страниц как контейнер Docker, который может взаимодействовать с Redis, запущенным в другом контейнере. Такая настройка полезна для разработки и тестирования, а также для развертывания вашего приложения в удаленной среде. Даже если вы не установили Python или Redis на свой компьютер, вы все равно сможете запустить свой проект через Docker.

Понимать терминологию Docker

Настройка приложения включает в себя создание Файла настройки, который представляет собой декларативное описание желаемого состояния вашей среды. Он предоставляет шаблон для среды выполнения, конфигурацию и все зависимости и библиотеки, необходимые для запуска вашего приложения.

Чтобы вдохнуть жизнь в ваше приложение, вы должны создать Образ Docker на основе этого описания. Образ Docker можно рассматривать как моментальный снимок вашей операционной системы на данный момент времени. Когда вы делитесь своим образом Docker со всем миром или внутри своей компании, другие пользователи могут воспроизводить точно такую же среду и запускать то же приложение, что и вы. Это устраняет классическую проблему , но она работает на моем компьютере.

Образ Docker - это схема для Контейнеров Docker. Каждый контейнер Docker - это экземпляр вашего образа Docker. Контейнер обладает независимым состоянием и ресурсами, включая собственную файловую систему, переменные среды и сетевые интерфейсы. В одном контейнере Docker обычно выполняется один процесс, что делает его идеальным для размещения определенного микросервиса.

Добавляя дополнительные контейнеры, вы можете временно увеличить масштаб одного или нескольких микросервисов, чтобы справиться с пиковым трафиком, который может быть характерен, например, для сезона отпусков. Однако для того, чтобы это было эффективно, ваши микросервисы должны быть хорошо спроектированы и не иметь состояния.

Примечание: Контейнеры Docker напоминают виртуальные машины, такие как Vagrant или VirtualBox, но они гораздо легче и быстрее настраиваются. В результате вы можете одновременно запускать на вашем хост-компьютере гораздо больше контейнеров, чем виртуальных машин.

Причина этого в том, что у контейнеров меньше накладных расходов, поскольку они совместно используют ядро вашей операционной системы, в то время как виртуальные машины работают на гипервизоре который эмулирует весь аппаратный стек. С другой стороны, контейнеры не так безопасны и не обеспечивают такой же уровень изоляции, как виртуальные машины.

Типичные приложения состоят из нескольких служб, работающих в изолированных контейнерах Docker, которые могут взаимодействовать друг с другом. В вашем приложении для отслеживания страниц есть эти две функции:

- Веб-служба

- Служба Redis

Вы уже знаете, как запускать Redis через Docker. Теперь пришло время изолировать ваше веб-приложение Flask в контейнере Docker, чтобы упростить процесс разработки и развертывания обоих сервисов.

Изучите анатомию файла Dockerfile

Для начала вы определите относительно короткий файл Dockerfile, который будет применим на этапе разработки. Создайте файл с именем Dockerfile в корневой папке вашего проекта на том же уровне, что и подпапка src/ и файл конфигурации pyproject.toml в файловой иерархии:

page-tracker/

│

├── src/

│ └── page_tracker/

│ ├── __init__.py

│ └── app.py

│

├── test/

│

├── venv/

│

├── constraints.txt

├── Dockerfile

└── pyproject.toml

Вы можете назвать этот файл так, как вам нравится, но соблюдение соглашения об именовании по умолчанию избавит вас от необходимости указывать имя файла каждый раз, когда вы захотите создать изображение. Имя файла по умолчанию, которое ожидает Docker, будет Dockerfile без расширения файла. Обратите внимание, что оно начинается с заглавной буквы D.

Файл Dockerfile - это обычный текстовый документ, в котором перечислены шаги, необходимые для сборки изображения. Он соответствует определенному формату, который определяет фиксированный набор инструкций, которые вы должны использовать.

Примечание: Вы должны размещать каждую инструкцию в вашем файле Dockerfile в отдельной строке, но нередко можно увидеть, что действительно длинные строки несколько раз разбиваются на строки символ продолжения (\). На самом деле, чтобы воспользоваться преимуществами механизма кэширования, о котором вы сейчас узнаете, часто требуется выполнить более одной операции в одной строке.

Когда вы создаете изображение из файла Dockerfile, вы полагаетесь на последовательность слоев. Каждая команда создает слой, доступный только для чтения, поверх предыдущего слоя, инкапсулируя некоторые изменения в файловой системе, лежащей в основе изображения. Слои имеют уникальные в глобальном масштабе идентификаторы, которые позволяют Docker сохранять слои в кэше. Это имеет два основных преимущества:

- Скорость: Docker может пропускать слои, которые не менялись с момента последней сборки, и загружать их из кэша, что значительно ускоряет сборку изображений.

- Размер: Несколько изображений могут иметь общие слои, что уменьшает их индивидуальный размер. Кроме того, меньшее количество слоев приводит к уменьшению размера изображения.

Теперь, когда вы знакомы с многоуровневой структурой файла Dockerfile, вы можете начать добавлять к нему инструкции, одновременно изучая рекомендации по созданию эффективных образов Docker.

Выберите базовый образ Docker

Первая инструкция в каждом файле Dockerfile, FROM, всегда должна определять базовый образ, из которого будет создан ваш новый образ. Это означает, что вам не нужно начинать с нуля, но вы можете выбрать подходящее изображение, которое уже создано. Например, вы можете использовать изображение, поставляемое с интерпретатором Python:

# Dockerfile

FROM python:3.11.2-slim-bullseye

Здесь вы используете официальный образ Python с именем python, который размещен на Docker Hub. Официальные изображения создаются и поддерживаются официальными разработчиками соответствующего языка или технологии. Они не принадлежат какому-либо конкретному пользователю или команде в Docker Hub, но доступны в глобальном пространстве имен, неявно называемом library/, в отличие от более специализированных вариантов, таких как circleci/python.

Вы также можете указать необязательную метку или название тега после двоеточия (:), чтобы сузить выбор конкретной версии базового изображения. Вы можете просмотреть все доступные теги данного изображения Docker, нажав на вкладку Теги на соответствующей странице Docker Hub.

Примечание: Теги не являются обязательными, но их включение в инструкцию FROM считается оптимальной практикой. Вы должны быть максимально конкретны, чтобы избежать нежелательных сюрпризов. Если вы опустите этот тег, то Docker выдаст изображение с тегом latest, которое может содержать неподходящую операционную систему или неожиданные изменения в среде выполнения, влияющие на ваше приложение.

Тег 3.11.2-slim-bullseye означает, что ваш базовый образ будет представлять собой уменьшенный вариант Debian Bullseye, содержащий только самое необходимое, что позволит вам позже установить любые дополнительные пакеты по мере необходимости. Это уменьшает размер изображения и ускоряет его загрузку. Разница в размере между обычным и тонким вариантами этого изображения составляет целых восемьсот мегабайт!

Тег также указывает на то, что ваш базовый образ будет поставляться с уже установленным Python 3.11.2, так что вы можете начать использовать его прямо сейчас.

Следующая задача, которую вы, возможно, захотите выполнить сразу после создания базового образа, - это установить на него самые последние обновления для системы безопасности и исправления ошибок, который, возможно, был выпущен с момента публикации изображения на Docker Hub:

# Dockerfile

FROM python:3.11.2-slim-bullseye

RUN apt-get update && \

apt-get upgrade --yes

В Debian вы используете команду apt-get, чтобы получить список последних пакетов и обновить все пакеты, для которых доступны обновления. Обратите внимание, что обе команды выполняются как часть одной инструкции RUN чтобы минимизировать количество уровней в файловой системе, вы не занимаете слишком много места на диске.

Примечание: Порядок следования инструкций в вашем файле Dockerfile важен, поскольку он может повлиять на то, сколько времени потребуется для создания образа. В частности, вам следует размещать инструкции, уровни которых часто меняются в нижней части вашего файла Dockerfile, потому что они, скорее всего, сделают недействительными все последующие уровни в кэше.

Итак. Вы выбрали базовый образ и установили последние обновления для системы безопасности. Вы почти готовы к настройке приложения Flask, но впереди еще несколько шагов.

Изолируйте свой образ Docker

Еще одна полезная практика при работе с Dockerfiles - создать и переключиться на обычного пользователя без административных привилегий, как только они вам больше не понадобятся. По умолчанию Docker выполняет ваши команды от имени суперпользователя, что может быть использовано злоумышленником для получения неограниченного доступа к вашей хост-системе. Да, Docker предоставляет доступ на корневом уровне к контейнеру и вашему хост-компьютеру!

Вот как вы можете избежать этой потенциальной угрозы безопасности:

# Dockerfile

FROM python:3.11.2-slim-bullseye

RUN apt-get update && \

apt-get upgrade --yes

RUN useradd --create-home realpython

USER realpython

WORKDIR /home/realpython

Вы создаете нового пользователя с именем realpython и указываете Docker использовать этого пользователя в файле Dockerfile с этого момента. Вы также устанавливаете текущий рабочий каталог в качестве домашнего каталога этого пользователя , чтобы вам не приходилось явно указывать полный путь к файлу в последующих командах.

Даже если в вашем контейнере Docker будет запущено одно приложение Flask, рассмотрите возможность создания выделенной виртуальной среды внутри самого контейнера. Хотя вам не нужно беспокоиться об изоляции нескольких проектов на Python друг от друга, а Docker обеспечивает достаточный уровень изоляции от вашего хост-компьютера, вы все равно рискуете вмешаться в работу собственных системных инструментов контейнера.

К сожалению, для бесперебойной работы многих дистрибутивов Linux требуется глобальная установка Python. Если вы начнете устанавливать пакеты непосредственно в глобальную среду Python, то откроете дверь для потенциальных конфликтов версий. Это может даже привести к поломке вашей системы.

Примечание: Если вы все еще сомневаетесь в создании виртуальной среды внутри контейнера Docker, то, возможно, это предупреждающее сообщение изменит ваше мнение:

WARNING: Running pip as the 'root' user can result in broken permissions

and conflicting behaviour with the system package manager. It is

⮑recommended to use a virtual environment instead:

⮑https://pip.pypa.io/warnings/venv

Вы можете увидеть это после попытки установить пакет Python с помощью системной глобальной команды pip в Debian или производном дистрибутиве, таком как Ubuntu.

Самый надежный способ создать и активировать виртуальную среду в вашем образе Docker - это напрямую изменить ее PATH переменную окружения:

# Dockerfile

FROM python:3.11.2-slim-bullseye

RUN apt-get update && \

apt-get upgrade --yes

RUN useradd --create-home realpython

USER realpython

WORKDIR /home/realpython

ENV VIRTUALENV=/home/realpython/venv

RUN python3 -m venv $VIRTUALENV

ENV PATH="$VIRTUALENV/bin:$PATH"

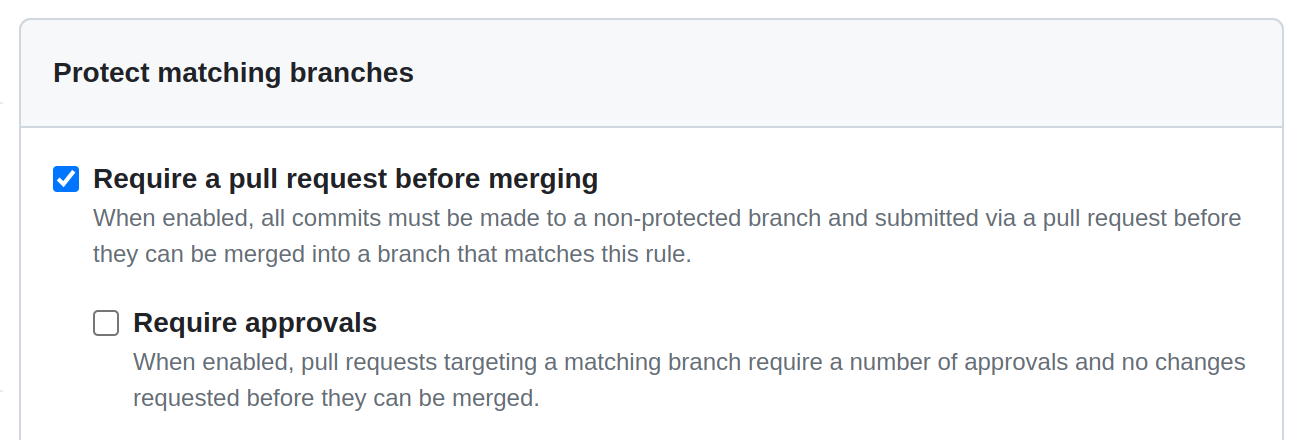

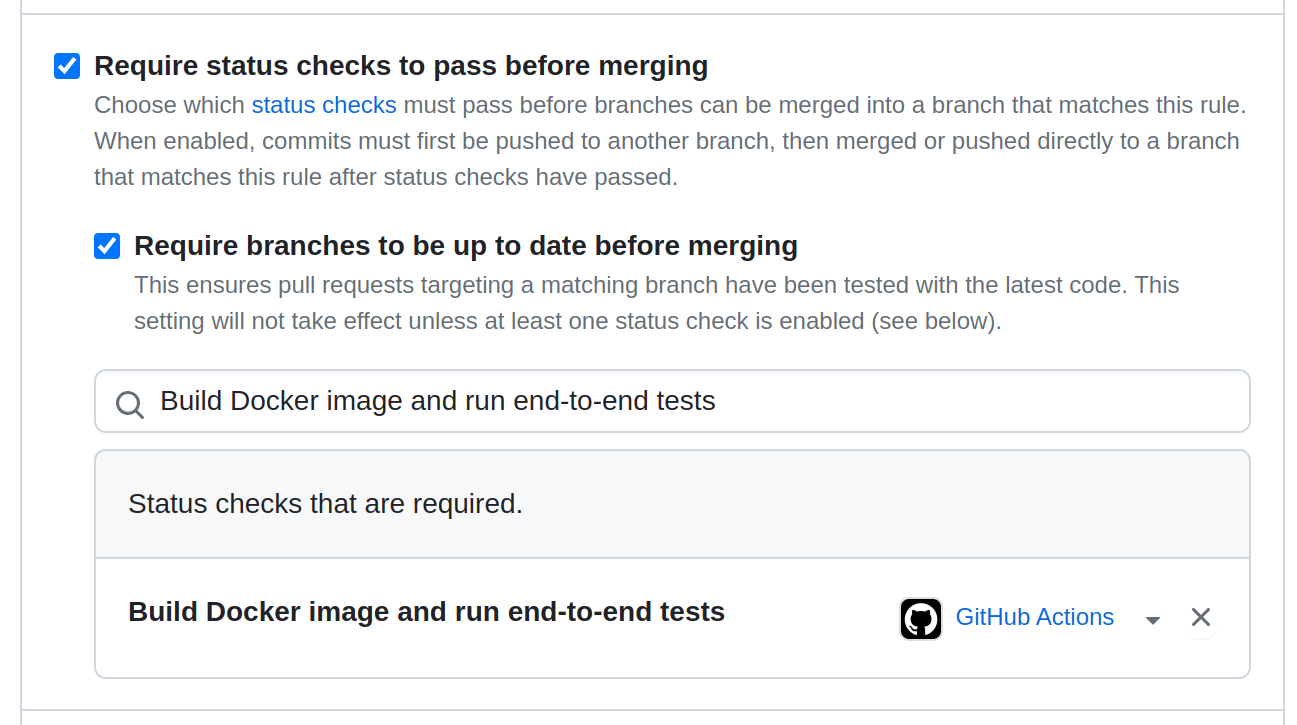

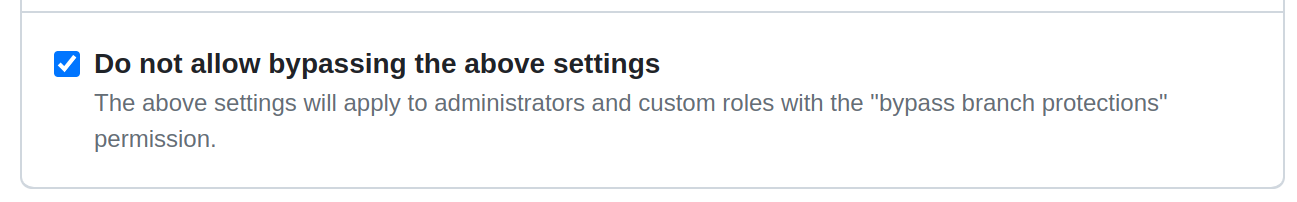

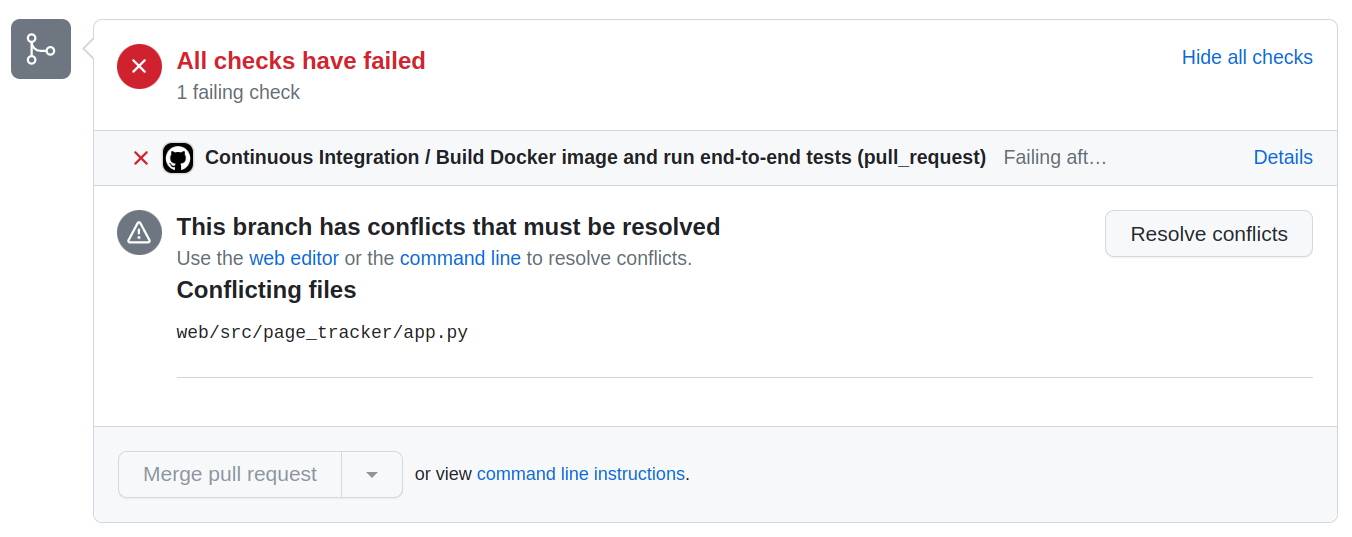

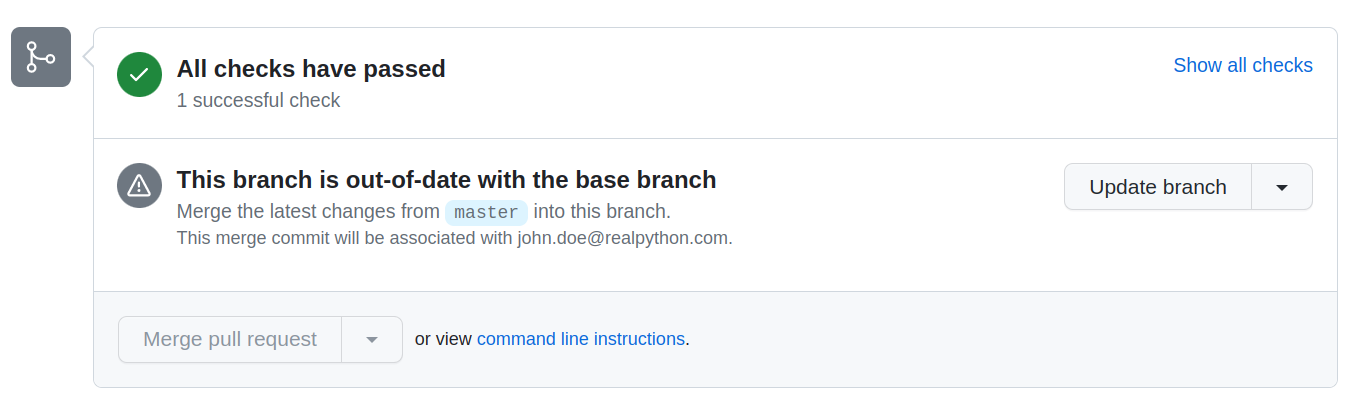

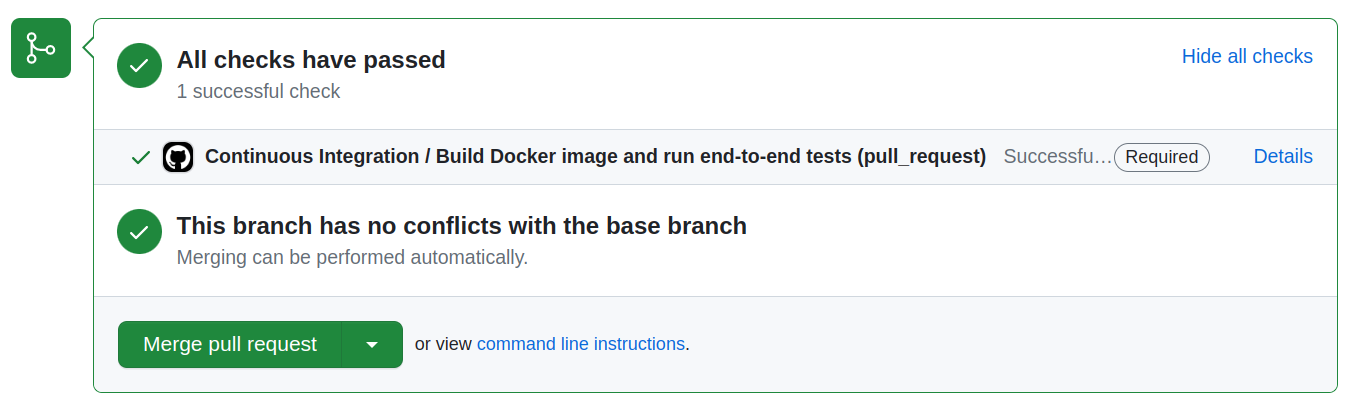

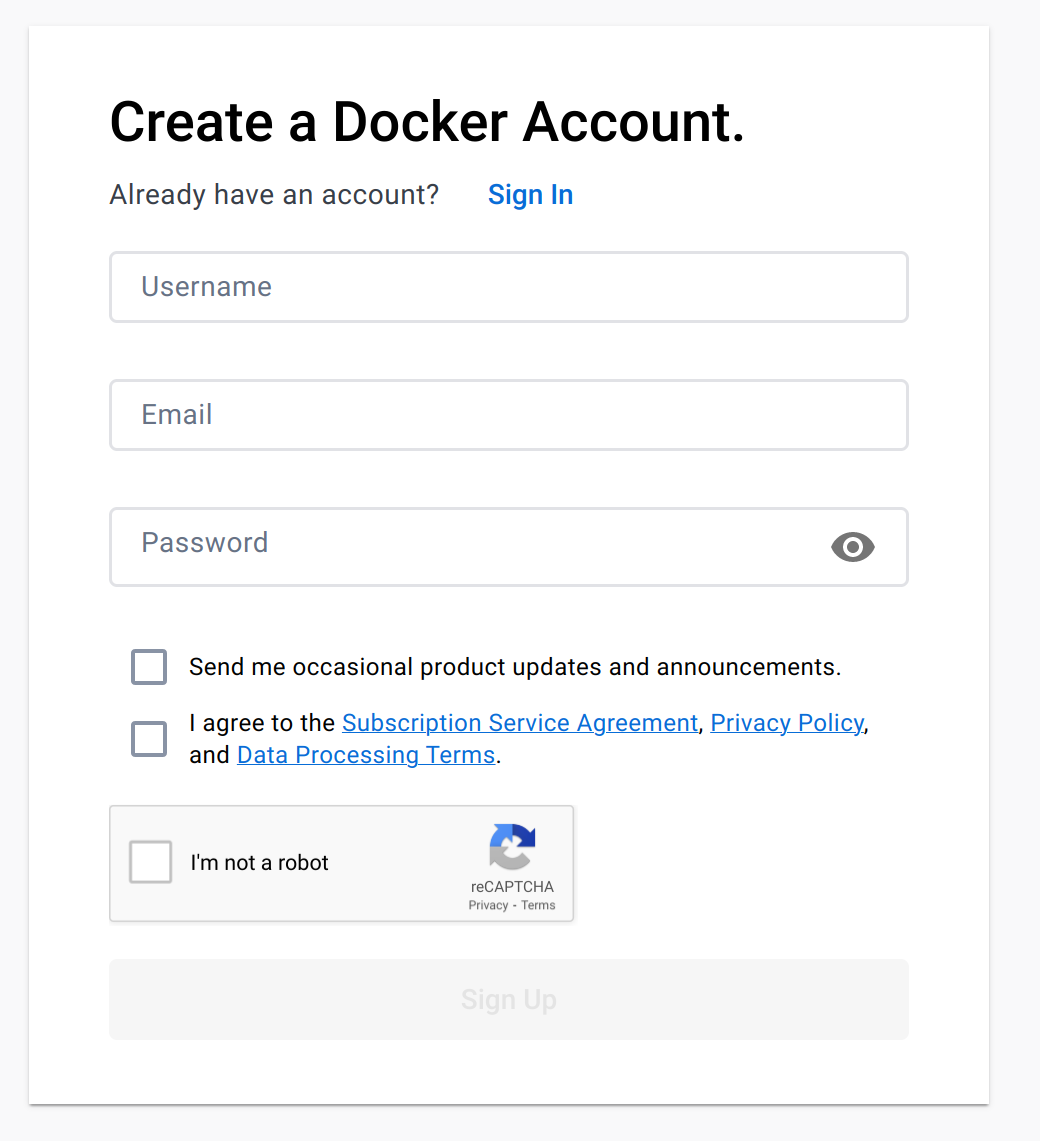

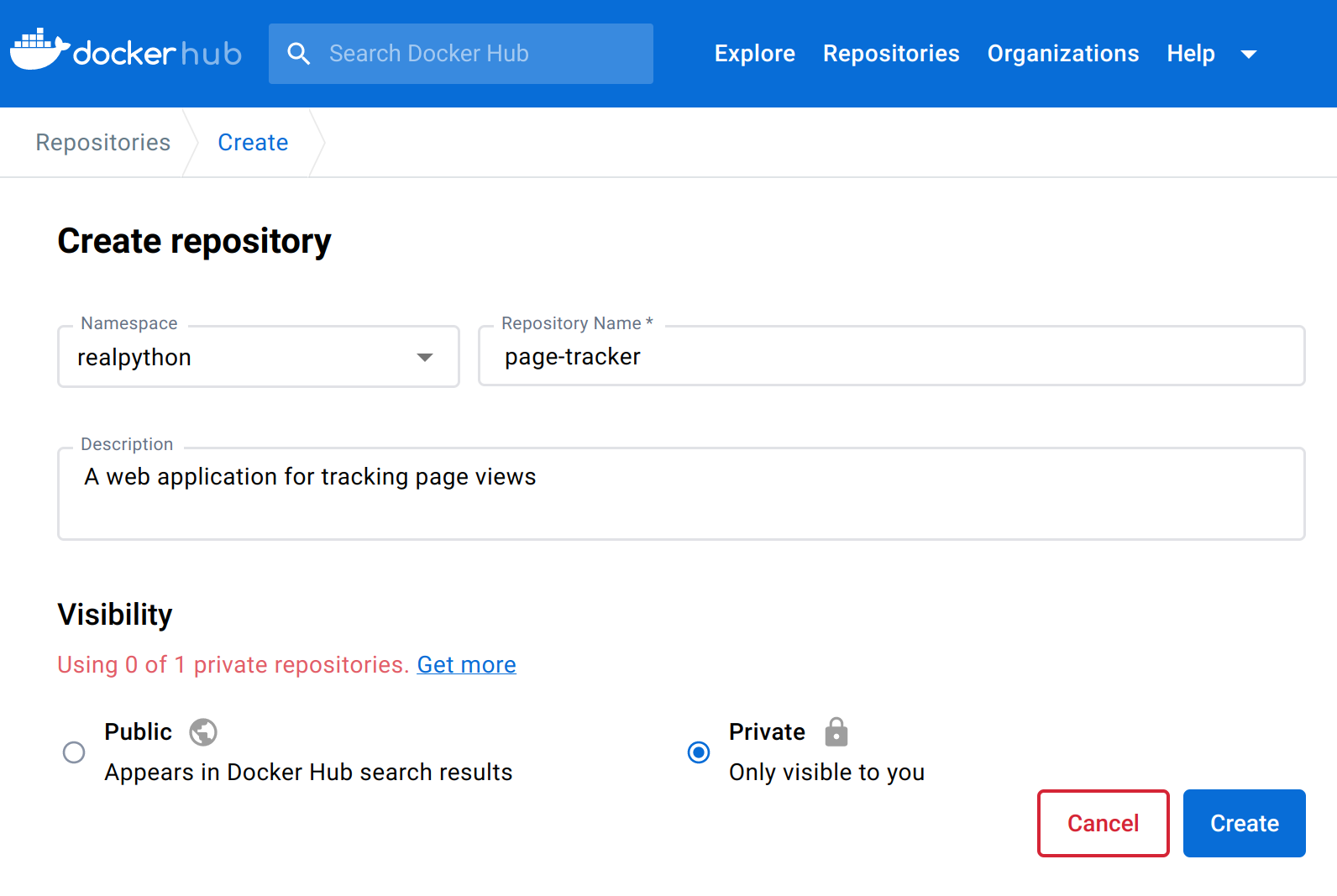

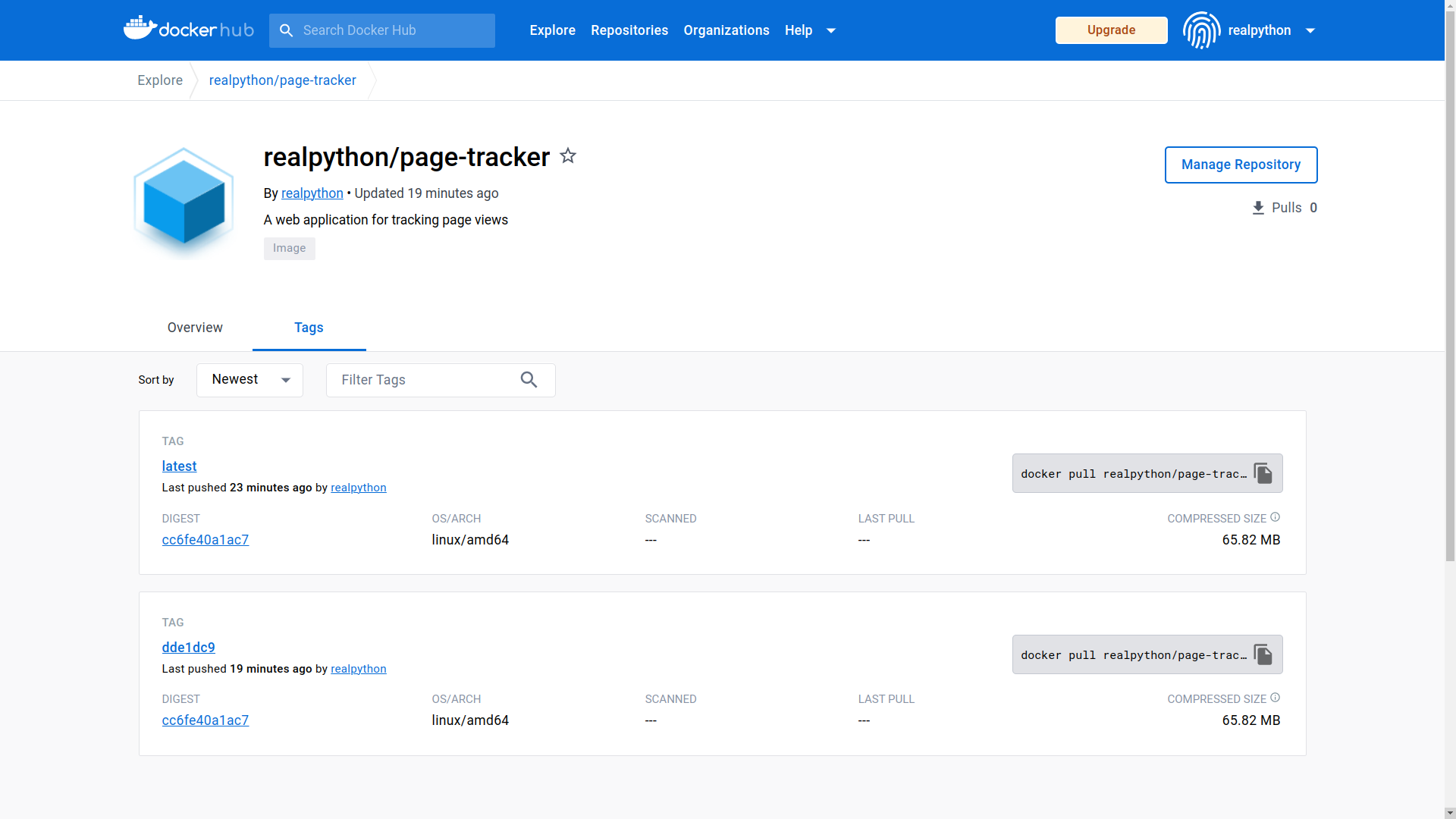

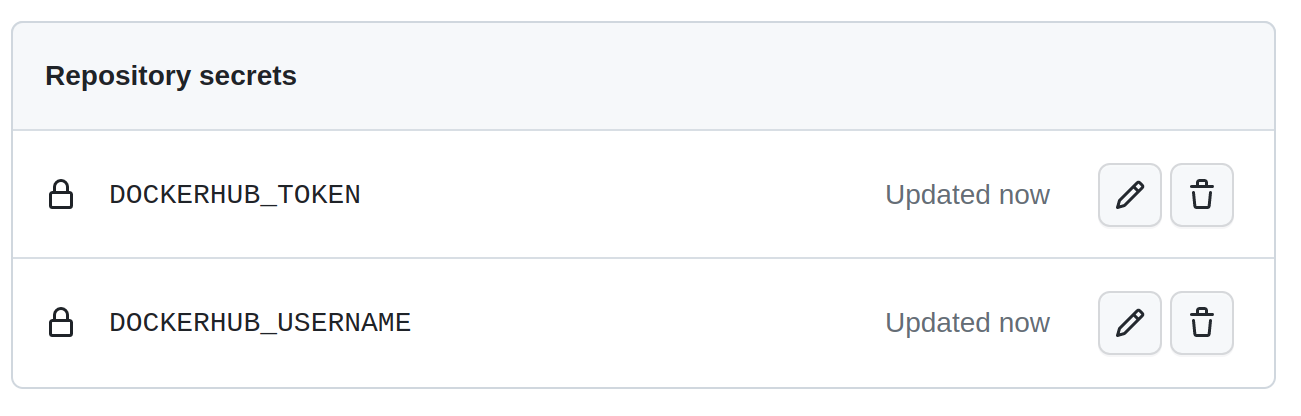

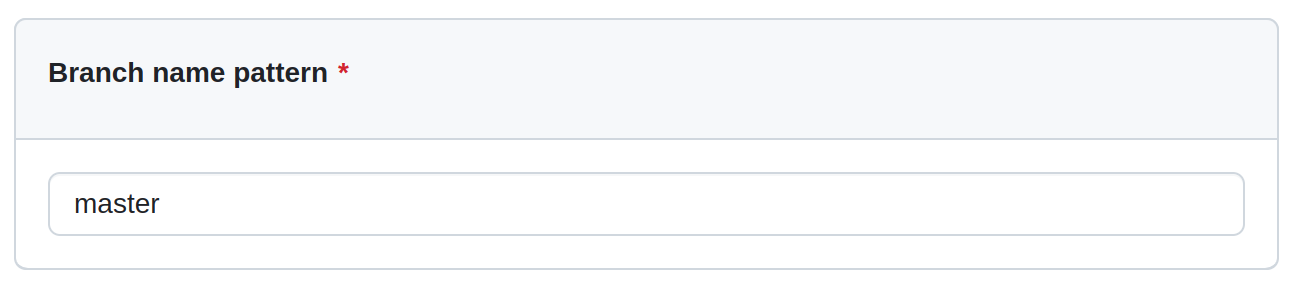

Сначала вы определяете вспомогательную переменную VIRTUALENV с указанием пути к виртуальной среде вашего проекта, а затем используете модуль Python venv для создания этой среды. Однако вместо того, чтобы активировать новую среду с помощью сценария оболочки, вы обновляете переменную PATH, переопределяя путь к исполняемому файлу python.